Berechnung der farbigen Pixel

Ein CCD- oder CMOS-Sensor, wie er bei Digitalkameras verwendet wird, kann nur Helligkeitsinformationen erkennen. Er könnte daher eigentlich nur schwarz-weiße Bilder aufnehmen. Um trotzdem Farbbilder zu erhalten, ist der Sensor mit Farbfiltern versehen. Die Sensorpixel sind also abwechselnd mit roten, grünen und blauen Filtern abgedeckt. Entsprechend sind sie auch abwechselnd nur für rotes, grünes oder blaues Licht empfänglich. Aus den Messwerten von drei solchen einfarbigen Sensorpixeln kann dann ein "echtfarbiges" Bildpixel zusammengesetzt werden.

Würde die Kamera so vorgehen, hätten die fertigen Bilder nur ein Drittel der Pixelzahl des Sensors: Eine Kamera mit 10 MP-Sensor würde also nur 3,3 MP große Bilder speichern.

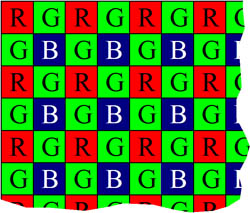

Die Hersteller haben sich etwas anderes einfallen lassen. Die Verteilung der Farbfilter auf dem Sensor sieht etwa so aus:

Es fällt auf, dass 50% der Pixel einen grünen Filter haben und nur je 25% einen roten oder blauen. Das liegt daran, dass das menschliche Auge grüne Farbschattierungen besser auflösen kann als andersfarbige. Dies wird durch den Kamerasensor nachgebildet. Man nennt diese Filteranordnung nach ihrem Erfinder "Bayer-Matrix".

Für die Umrechnung in Bildpixel werden nun immer die Kreuzungsstellen betrachtet, an denen vier Sensorpixel aneinander stoßen. An jeder Kreuzungsstelle kann man nun die Farbe aus den Messwerten je eines roten, eines blauen und zweier grüner Pixel berechnen. Das fertige Bild hat dadurch fast genauso viele Pixel wie der Sensor. Das Verfahren führt aber auch dazu, dass jeder Sensorpixel den Rot-, Grün- oder Blauanteil von gleich vier Bildpunkten des fertigen Bildes bestimmt.

Beim Bildeindruck führt das Verfahren zu etwas geringerer Bildschärfe als wenn jeder Bildpunkt aus Sensorpixeln in den drei Grundfarben zusammengesetzt wäre. Dafür könnte man eine Kamera mit technisch 15 Megapixeln nur noch als 5 Megapixel-Modell vermarkten.