Künstliche Intelligenz in der Bildaufbereitung der Apple iPhones

Smartphones sorgten und sorgen nicht zuletzt dank Bildverbesserungen mittels künstlicher Intelligenz für sinkende Verkaufszahlen der Kompaktkameras sowie der Einsteiger-Systemkameras.

Im folgenden erkläre ich einige der Bildverbesserungs-„Tricks“, die Apple iPhones vermutlich seit der Generation iPhone 8 bzw. gesichert seit der Generation 11 für die Bildaufbereitung nutzen und zeige einige Bildbeispiele, die diese Techniken veranschaulichen.

Was ist künstliche Intelligenz?

Laut Wikipedia ist KI bzw. AI (Artifizielle Intelligenz) ein Teilgebiet der Informatik und befaßt sich mit der Automatisierung von intelligentem Verhalten und dem maschinellen Lernen. Dabei werden Lernmuster „nachgebaut“, die auch ein Mensch beim Lernen durchläuft. Im Gegensatz zu vorgegebenen Computeralgorhythmen, die ein menschlicher Programmieren schreibt und damit den Programmablauf definiert, „lernt“ die KI anhand von Vorgaben, Entscheidungen zu treffen. Bei der Bildbearbeitung z. B. werden der KI tausende oder Millionen Fotos gezeigt, die sie analysiert und daraus bestimmte Muster extrahiert, um später z. B. Verkehrsschilder oder Gesichter im „realen Leben“ zu erkennen.

Z. B. gibt es eine KI-Software, die trainiert wurde, die Malweise berühmter Künstler nachzubilden und ein Foto in ein Gemälde zu verwandeln, das so aussieht, als stamme es von van Gogh, Raffael oder Edvard Munch. KI kann aber auch verwendet werden, um in vorhandenen Videos Gesichter auszutauschen, inzwischen sind diese Systeme so gut, daß die „Fakevideos“ kaum noch als Fälschungen erkennbar sind. Es gibt ein Buch einer Science-Fiction-Reihe, daß nicht vom Autor selbst, sondern von einer KI „geschrieben“ wurde, oder Beethovens „10. Sinfonie“, die eine KI „komponierte“.

Künstliche Intelligenz in der Bildbearbeitung

Ralf Jannke hat auf dieser Website einige Computerprogramme vorgestellt, die mittels KI = künstlicher Intelligenz digitale Bilder während der Bildbearbeitung am heimischen Rechner verbessern, diese Berichte sind unter folgenden Links nachlesbar:

- Topaz Gigapixel AI zur Vergrößerung

- Topaz DeNoise AI zur Bildrausch-Reduktion

- Topaz Sharpen AI zum Nachschärfen

Künstliche Intelligenz in den Smartphones von Apple

Apple hat seit dem iPhone 8 (Link:https://www.digicammuseum.de/gechichten/erfahrungsberichte/apple-iphone-8-c-zahn/) bzw. dem iPhone X aus dem Jahre 2017 eine „Neural Engine“ = NPU = „Neutral Processing Unit“ auf dem Haupt-Rechenchip „A11 Bionic“ integriert. Im iPhone X und späteren Modellen arbeitet diese mehrkernige Recheneinheit mit an der Gesichtserkennung zum Entsperren des Smartphones und für Anwendungen, die virtuellen Objekte in von der Kamera aufgenommene Motive einblenden (Augmented Reality). Außerdem kümmert sie sich auch um die Bildverbesserung aufgenommener Bilder bzw. Videos. Des Weiteren verbessert sie die Spracherkennung der „Siri“-Sprachsteuerung.

Außerdem werden von der Apple-Kamera-App bzw. von Fremd-Apps zur Bild- und Videoaufzeichnung die Kerne des Hauptprozessors und die Kerne des Grafikprozessor mitverwendet. Wie in der iOS-Umgebung üblich dürfen Fremd-Apps nicht direkt mit all diesen Prozessoren kommunizieren, sondern nur über Apple-Systemaufrufe deren Funktionen nutzen.

Mindestens seit dem iPhone Xs (Link:https://www.digicammuseum.de/gechichten/erfahrungsberichte/apple-iphone-xs-c-zahn/) können Fremd-Apps seit iOS 13.2 die Bildverbesserungen nutzen, seit dem iPhone 11 (Link:https://www.digicammuseum.de/gechichten/erfahrungsberichte/apple-iphone-11-c-zahn/) stellt Apple die künstliche Intelligenz der Bildverbesserung in der Werbung für seine Smartphones deutlich heraus und bezeichnet die Technologie als „Deep Fusion“.Und wie allgemein üblich werden die CPU-, die GPU- und die NPU-Kerne von Generation zu Generation schneller und leistungsfähiger, so daß ein 2022 erschienenes iPhone 14 mit 16 NPU-Kernen wesentlich mehr Rechenleistung hat als ein iPhone 11 aus dem Jahr 2019, das „nur“ 8 NPU-Kerne besitzt oder ein iPhone X mit lediglich 2 NPU-Kernen.

Die Verbesserungen der Deep-Fusion-Technologie im Einzelnen

Die Aufnahmen werden in folgenden Punkten verbessert:

Kontrastumfang (HDR = High Dynamic Range)

Bei Motiven, deren Kontrast den Kontrastumfang des iPhone-Kamerasensors überschreitet, nimmt das iPhone mehrere Aufnahmen in extrem kurzer Zeit hintereinander auf, wobei Empfindlichkeit und Belichtungszeit verändert werden (eine sogenannte Belichtungsreihe). Somit liegen Einzelbilder vor, in denen in den hellsten und den dunkelsten Motivdetails noch etwas zu erkennen ist. Diese Einzelbilder werden zu einem Gesamtbild verrechnet, wobei versucht wird, den natürlichen Bildeindruck möglichst zu erhalten.

Die Apple-Bildaufbereitung übertreibt dabei das HDR nicht, die entstandenen Bilder wirken nicht „künstlich“, wie es bei etlichen HDR-Kompositionen, die am Computer nachbearbeitet wurden, vorkommt, wenn der Bildbearbeiter bewußt oder unbewußt eine unnatürlich wirkende HDR-Verrechnung vorgenommen hatte. Die iPhone-HDRs sehen fast immer so aus, wie man die Szene während der Aufnahme mit seinen Augen auch sah.

Reduktion des Bildrauschens

Bei Aufnahmen, die höhere und hohe Sensorempfindlichkeiten erfordern, werden ebenfalls mehrere Aufnahmen in kürzester Zeit gemacht, allerdings mit nur sehr wenig veränderten Aufnahmeparametern. Bei jedem dieser Aufnahmen ist das Bildrauschen anders, so daß durch Zusammenrechnen dieser Aufnahmen das Rauschen erheblich gemindert wird. Außerdem wird durch KI-Berechnung versucht, nicht vorhandene bzw. im Rauschen „untergegangene“ Bilddetails zu ermitteln und diese somit wiederherzustellen. Apple nennt diese Bildbearbeitung „Nachtmodus“.

Bildschärfung

Die Kameras der iPhones nutzen sehr kleine Sensoren (Cropfaktor gegenüber KB ca. 5-6), diese haben üblicherweise Probleme mit der Bildschärfe. Die KI schärft anhand von erlernten Bildern die Details nach, ohne daß es zu übertriebenen Schärfe-Artefakten kommt, die rein algorhythmusbasierte Bildprozessoren erzeugen.

Bildvergrößerung

Beim iPhone 11 Pro erzeugt Deep Fusion aus mehreren Aufnahmen ein 24-Megapixel-Bild. Dabei werden genau wie in Foto-Systemkameras die einzelnen Bilder mit ganz geringfügig verschobenen Details aufgenommen, indem die optische Bildstabilisierung des iPhone-Kameramoduls um jeweils einen „halben“ Pixel nacheinander in alle vier Richtungen verschoben wird. Dieses Feature ist den wesentlich teureren Pro-Modellen vorbehalten, obwohl es in den „normalen“ iPhones auch funktionieren würde.

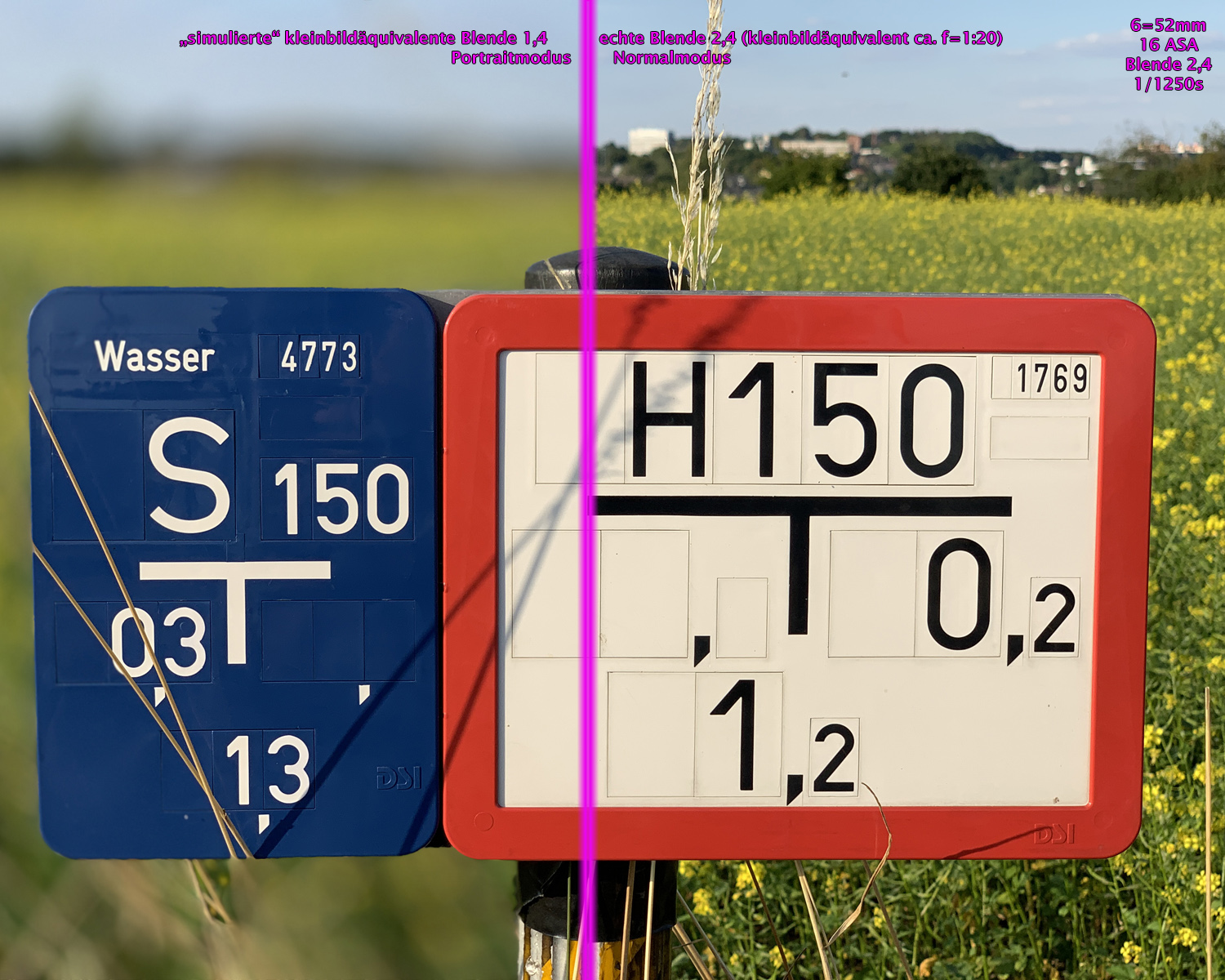

unscharfer Hintergrund im „Porträt“-Modus

Bei dieser Technik geschieht folgendes: Weil die Kameramodule der iPhones keine einstellbare Blende besitzen, nehmen sie immer mit Offenblende auf. Durch den extremen Cropfaktor gegenüber Kleinbild entspricht z. B. die Optik 1:1,8/4,25 mm des iPhone 11 ungefähr einem Kleinbildobjektiv 1:20/26mm. Deshalb ist die Tiefenschärfe der Aufnahmen enorm und recht meist von Unendlich bis kurz vor die Kameralinse.

Mit Hilfe der KI wird der Vorder- und der Hintergrund künstlich weichgezeichnet, um den Eindruck eines Kleinbildobjektivs mit weit geöffneter Blende zu simulieren. Bei den Selfiekameras auf der Display-Seite von iPhones mit Face ID wird dabei die mittels einer zusätzlichen Infrarotkamera und einem IR-Punktmuster-Projektor ermittelte räumliche Tiefenstaffelung herangezogen, bei der Hauptkamera auf der Rückseite werden die Tiefeninformationen aus dem Bild der zweiten Kamera mehr oder minder „erraten“ bzw. mit erlernten gespeicherten Mustern verglichen.

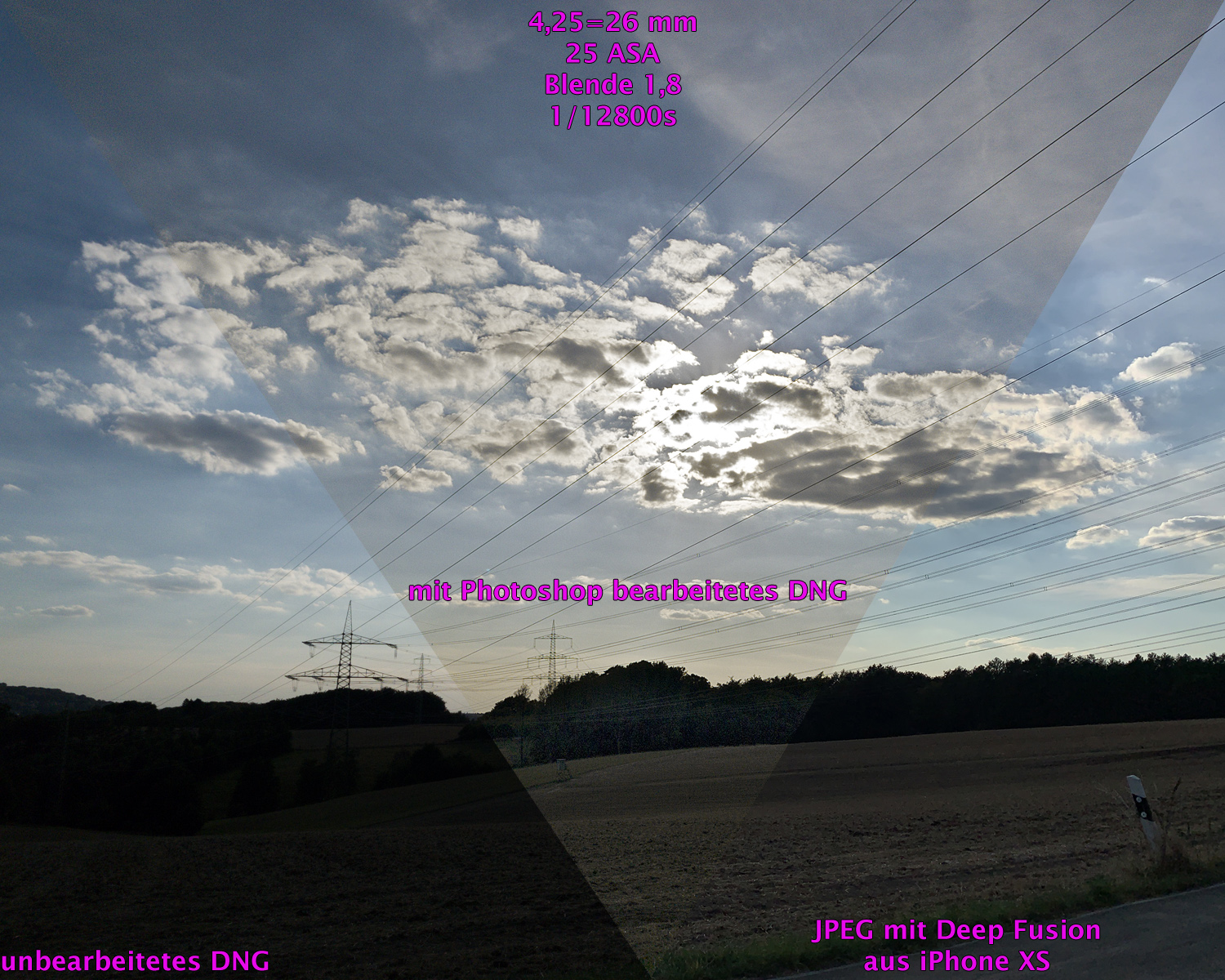

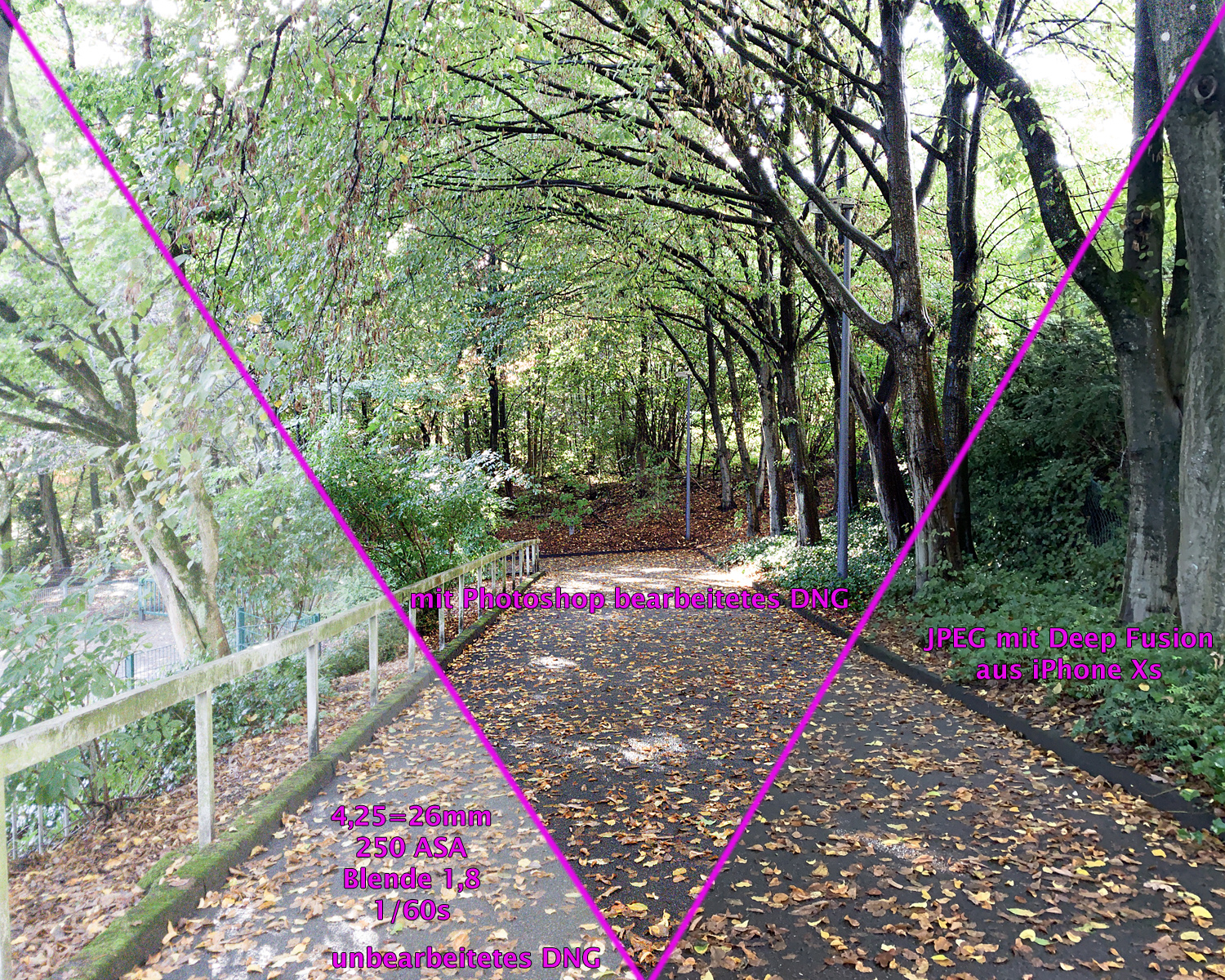

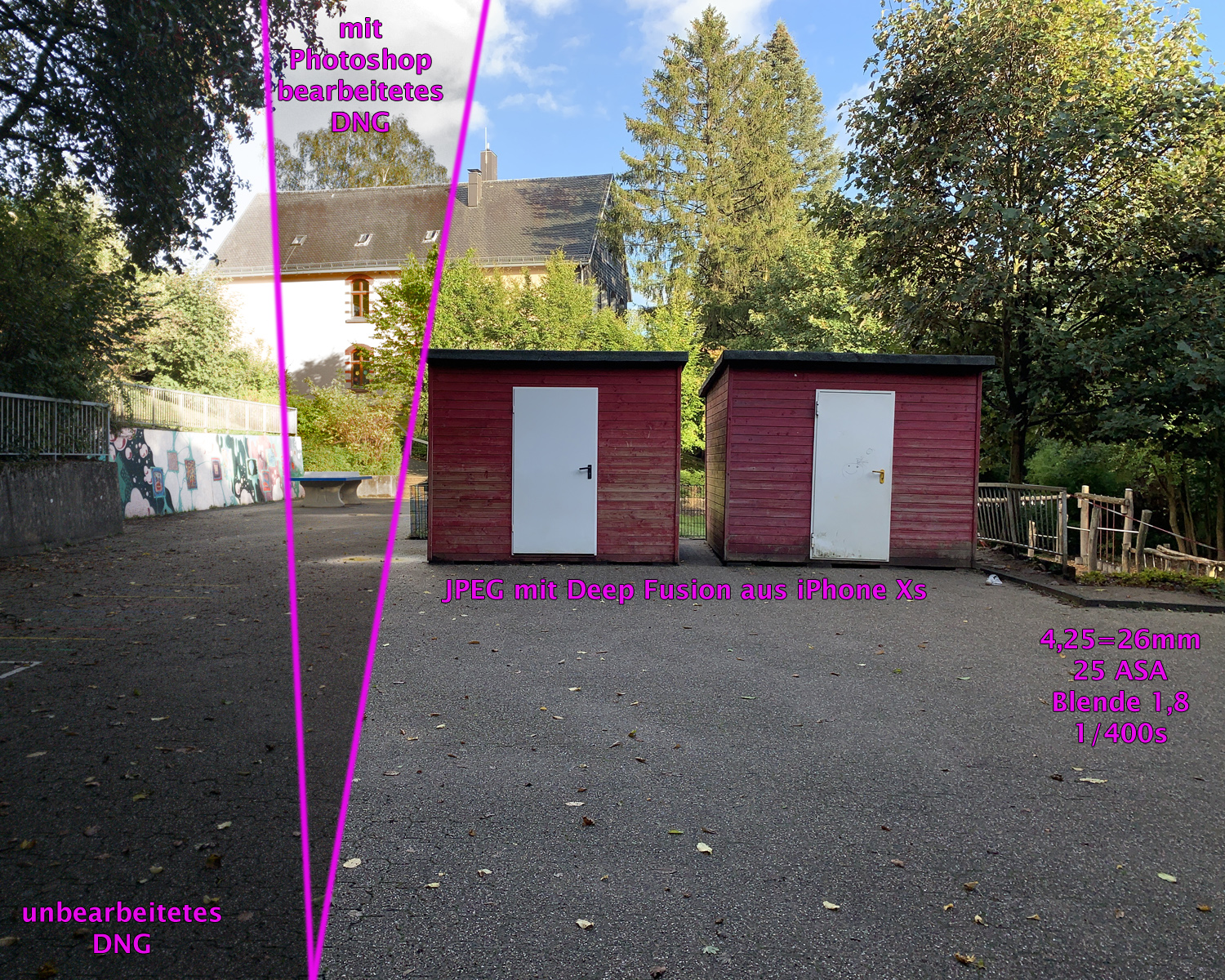

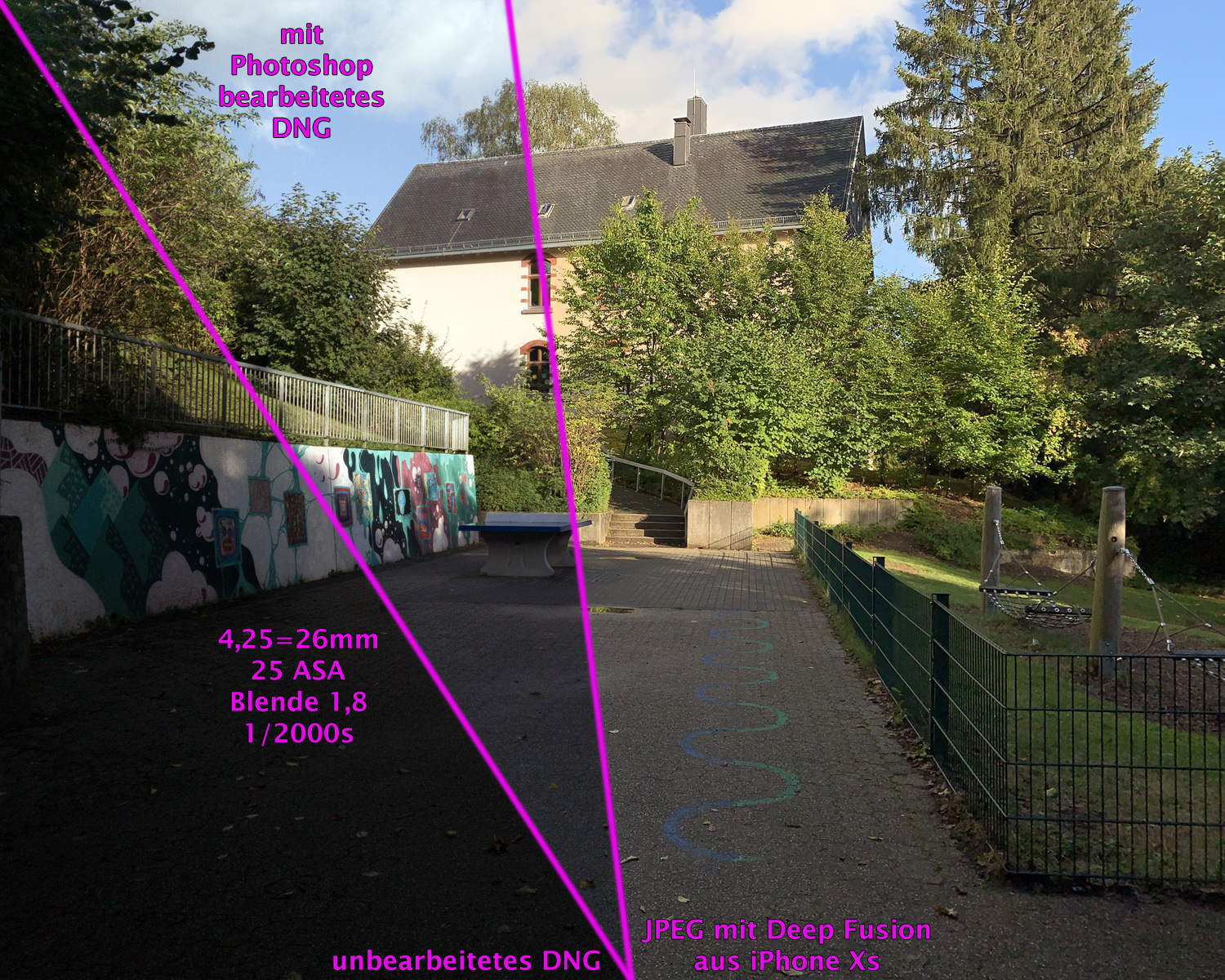

HDR-Bildbeispiele aus dem iPhone Xs

In den Beispielen sind sowohl das unbearbeitete DNG, das mit Hilfe von Photoshop nachbearbeite DNG und das vom iPhone Xs direkt erzeugte Bild zusammenmontiert. Das Photoshop-Bild hätte teilweise mit aufwendigerer EBV noch etwas verbessert werden können, der Arbeitsaufwand hätte aber einen längeren Zeitraum erfordert.

Die Ergebnisse sind teilweise beeindruckend, in manchen Fällen kann nicht einmal mit umfangreicher Bildbearbeitung eines DNG-RAW-Bildes in Photoshop das JPEG-Ergebnis aus dem iPhone Xs „nachgebaut“ werden, da das Smartphone mehrerer Aufnahmen mit unterschiedlicher Helligkeit zu einem stimmigem Bild zusammenrechnet. Um diese Bilder aus RAWs nachzubilden, müßten manuell mehrere Aufnahmen nacheinander mit unterschiedlicher Helligkeit aufgenommen werden, was ohne Stativ fast unmöglich ist.

Portrait-Bildbeispiele aus dem iPhone Xs

Die Ergebnisse sind teilweise beeindruckend, in manchen Fällen jedoch „rät“ die KI etwas daneben und läßt Bilddetails scharf, die bei echter Hintergrundunschärfe nicht scharf abgebildet würden. Z. B. ist etwas links unterhalb der 1,3 unter obigem Schild ein Grashalm im Hintergrund nicht korrekt bis an die Schildgrenze unscharf gerechnet worden, so daß das Bild an dieser Stelle unnatürlich wirkt.

Portrait-Bildbeispiele aus den iPhone Xs

Auch hier sind die Ergebnisse teilweise beeindruckend, in manchen Fällen jedoch „rät“ die KI etwas daneben und läßt Bilddetails scharf, die bei echter Hintergrundunschärfe nicht scharf abgebildet würden. Z. B. ist die Abgrenzung zwischen Schild und Hintergrund in Beispiel 1 nicht gut gelungen, es gibt Details, die unscharf gerechnet worden, obwohl sie zum Schild gehören als auch zwei Stellen des Drahtzauns, die eigentlich unscharf sein müßten. Beim zweiten Beispiel ist das Blatt besser gelungen, jedoch ist auch hier ein Teil des Gestrüpps irrtümlich unscharf gerechnet.

Man sollte der KI allerdings zugute halten, daß die Motive weit außerhalb des antrainiertem Bereiches liegen, denn der Portraitmodus ist für die Abbildung von Menschen, insbesondere Gesichtern, gedacht und in neueren Modellen auch mit etlichen Haustieren „kompatibel“.

Fazit

Die JPEG-Bilder aus dem iPhone Xs und 11 sind dank Deep Fusion so gut, daß ein HDR-Fotografieren mit RAW-Aufnahmen und Nachbearbeitung am Computer kein besseres, sondern häufig ein schlechteres Ergebnis ergibt. Lediglich die Pro-Modelle seit der Generation 12 ermöglichen es, das Ergebnis der KI als teilbearbeitetes RAW aufzuzeichnen und diese zuhause nochmals nachzubearbeiten.

Bei den Portrait-Bildern hingegen kann es sinnvoller sein, die Unschärfe am heimischen Computer zu erzeugen, sofern die Motive stark von angelerntem Bildinhalt der KI abweichen. Die Apple Kamera-App kann in den Einstellung so konfiguriert werden, daß neben dem bearbeitetem Portraitmodus-JPEG auch ein nicht weichgezeichnetes zusätzliches JPEG abgespeichert wird.

Apple als Entwickler der Hardware und des Betriebssystems kann Hard-und Software perfekt zusammenarbeiten lassen, so daß die oben gezeigten beeindruckenden Ergebnisse inzwischen völlig normal sind und darum das Mitnehmen einer anderen Kamera als dem iPhone vielen Menschen inzwischen sinnlos erscheint. Gerade Einsteiger-Systemkameras sind stark rückläufig in den Verkaufszahlen.

Ein kurzer Hinweis zu Smartphones anderer Hersteller: Auch diese nutzen inzwischen künstliche Intelligenz in ihrer Bildbearbeitung, allerdings ist das Android-„Universum“ stark zerklüftet, nur Google stellt Betriebssystem und Telefone selbst her, die meisten anderen Hersteller müssen das von Google gelieferte Betriebssystem an ihre Kamera- und Telefon-Hardware anpassen. Da ich keine Erfahrung mit Smartphones dieser Hersteller habe, kann ich zu den Bildergebnissen dieser Geräte keine Aussagen treffen, vermute aber, daß sie den iPhones teilweise kaum oder nicht nachstehen werden und sie evtl. sogar übertreffen könnten.

Christian Zahn

Neuen Kommentar schreiben

| Autor: | Christian Zahn |

| Mail senden | |

| Erstellt: | 26.03.2023 |

Kommentare (0)

Keine Kommentare gefunden!